Generative AI

中二でもわかる「生成AI」のしくみ!

中学生の娘にも分かりやすいようにChatGPTなどの生成AIの仕組みを説明してみる!

AIな出来事

まずは直近20年のAIの出来事のまとめ

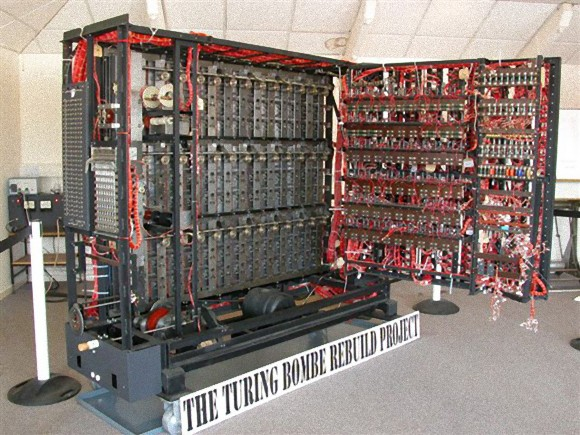

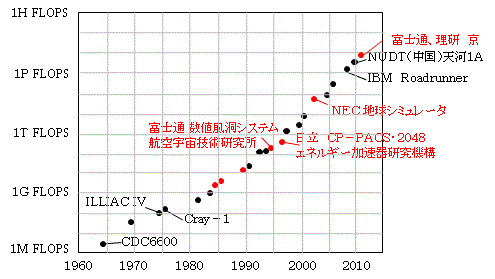

1997 Data Mining

DeepBlueがチェス世界チャンピオンに勝つ

IBMのDeepBlueコンピュータは、1秒間に2億手先を読む。

対戦相手の過去の棋譜を基に、次の差し手がどのくらい有効であるかを示す評価関数を、手動でセット。(チェスの総打ち手は35の80乗)

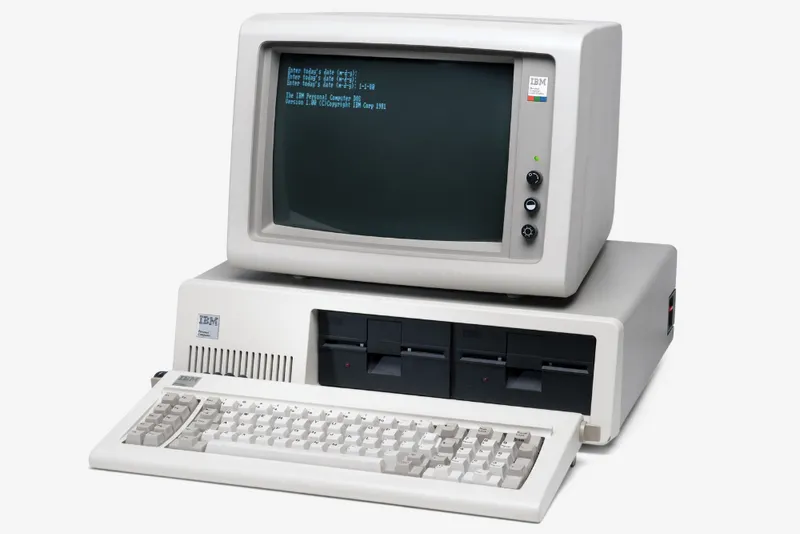

2011 Machine Learning

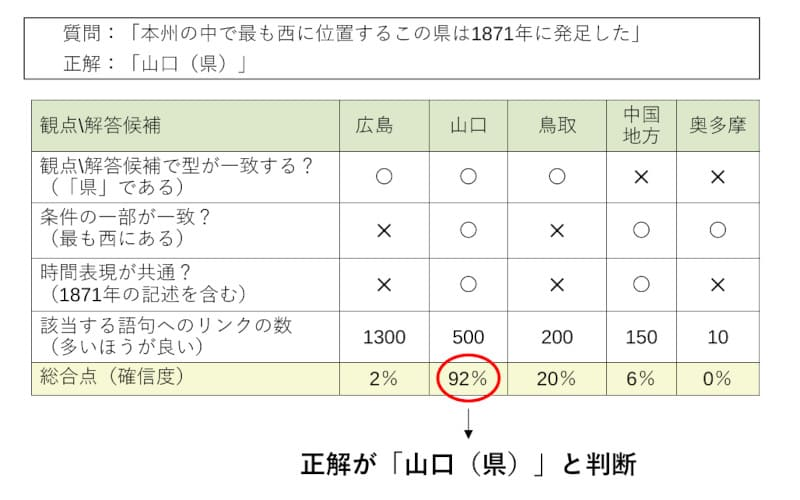

watsonがクイズ王者に勝つ

クイズに特化した文章、本・台本・百科事典(Wikipediaを含む)などの2億ページ分のテキストデータ(70Gb程度、約100万冊の書籍に相当)を取り込んで、その答えを質疑応答的に導く

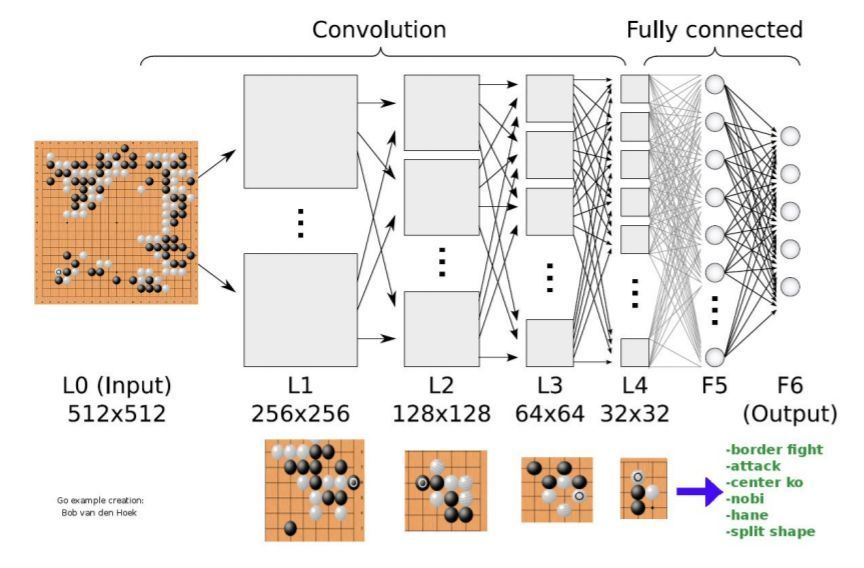

2016 Deep Learning

AlphaGoが囲碁世界チャンピオンに勝つ

囲碁の手数は250の150乗(チェスの1垓倍以上)となり、これは宇宙の分子の数よりも多い組み合わせ

2022 Generative AI

OpenAIによるChatGPTの登場

Generative AI / 生成AIとは

Deep Learning / 深層学習とは

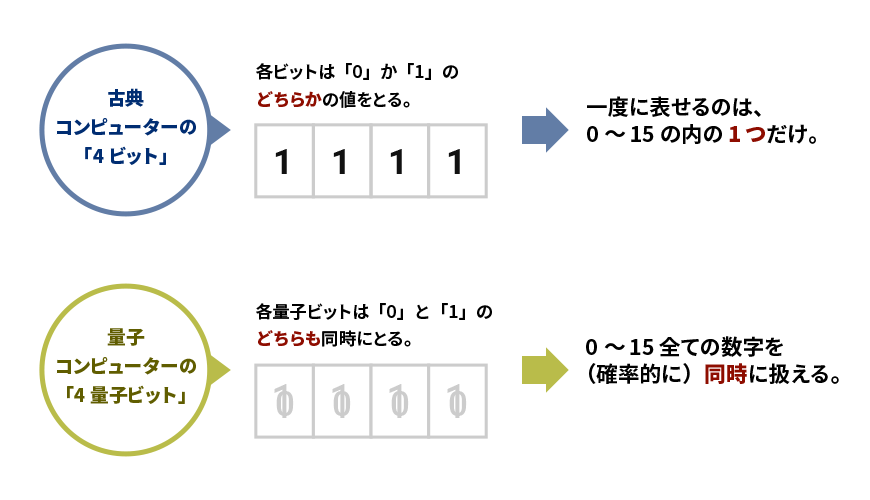

まず、生成AIを作るのに必ず必要なDeep Learning / 深層学習を学習してみる。

ChatGPTの元となる言語モデル(LLM)を作るために、Deep Learningは使われている。

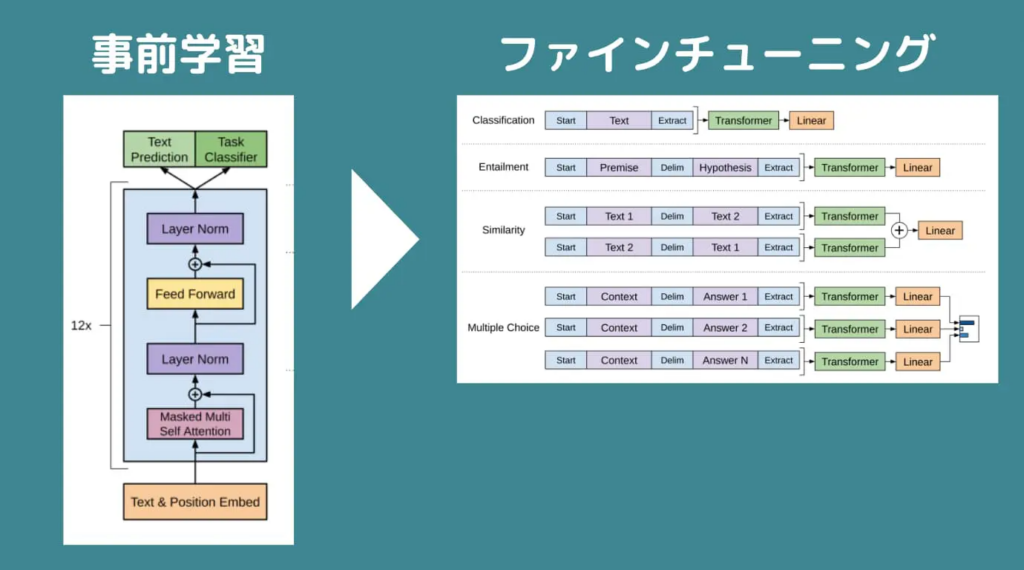

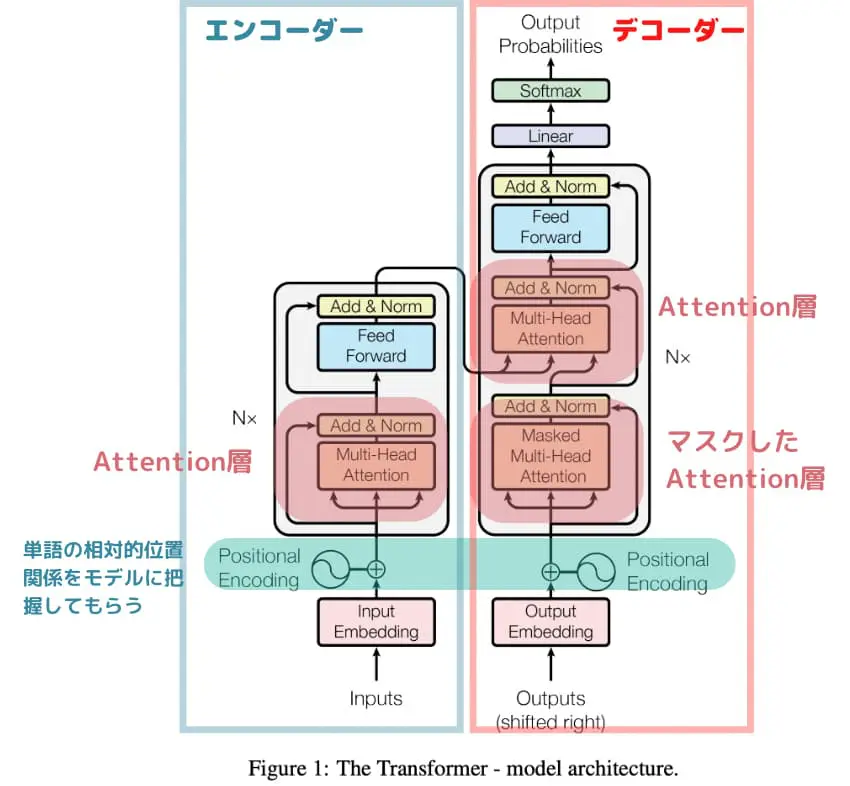

Deep Learningとして、まず2017年にGoogleの研究者らにより、Transformerの画期的な論文「Attention is all you need」が発表される。

次に、このTransformerの著者達がOpenAIに移り、2018年に「Generative Pre-trained」論文を発表する。

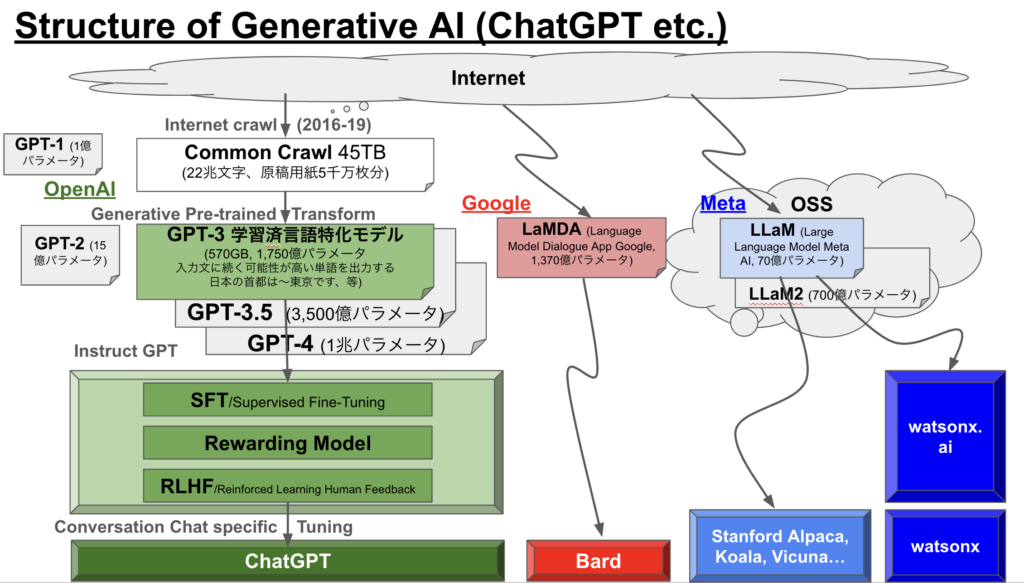

Genetative AIのしくみ

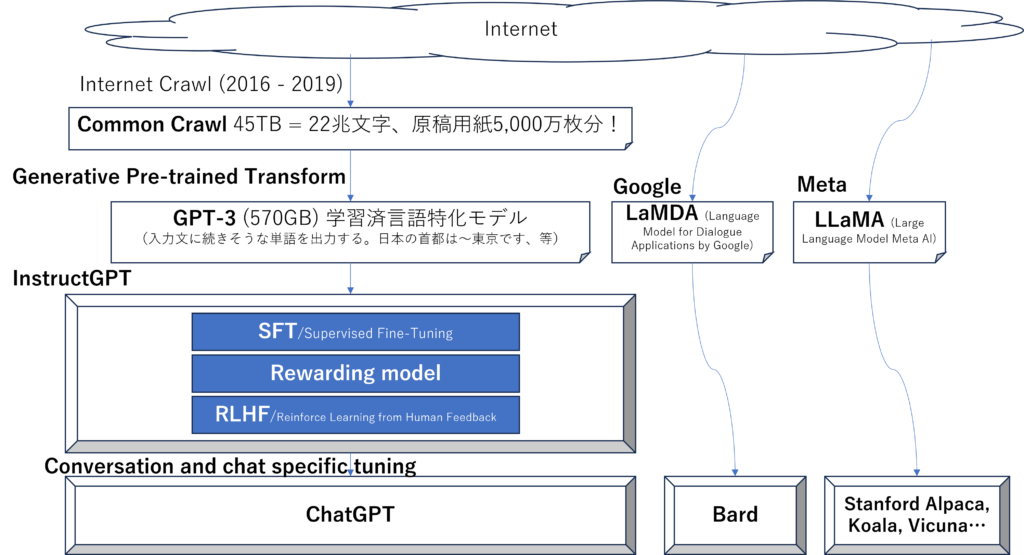

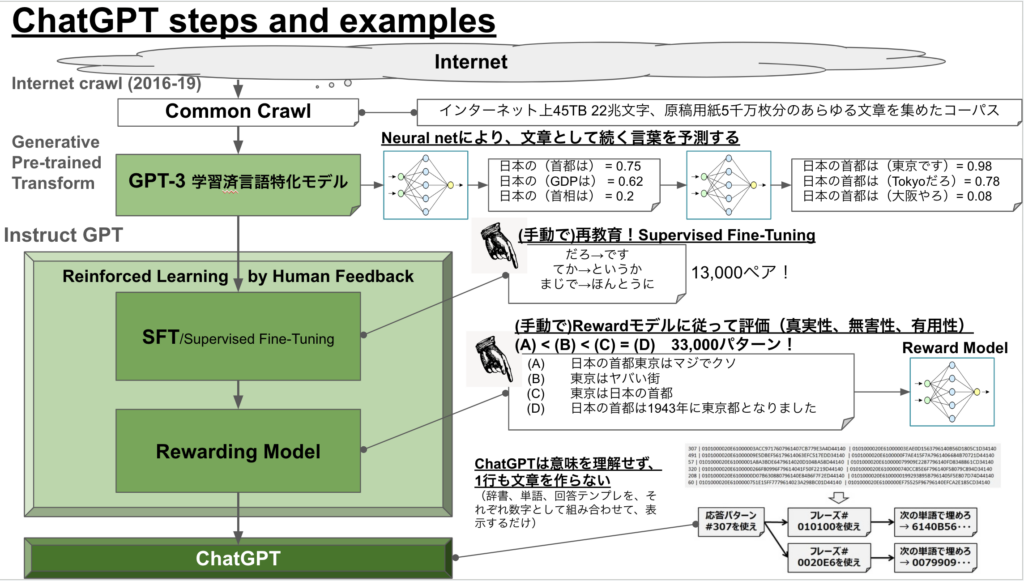

ChatGPT (OpenAI)では、学習済み言語モデル(GPT3などのLLM)を、人間として自然な言語として返すために、InstructGPTなどを使い生成している。

それ以外のLLMでは、Googleが文字検索から抽出したLaMDA(ラムダ)や、MetaがFacebook文字情報から生成したLLaMA(ラマ)がある。このうちLLaMAは(結果的に)公開情報OSSとなり、各大学やIBM等がこれを利用し独自の生成AI(watsonx等)を構築している。

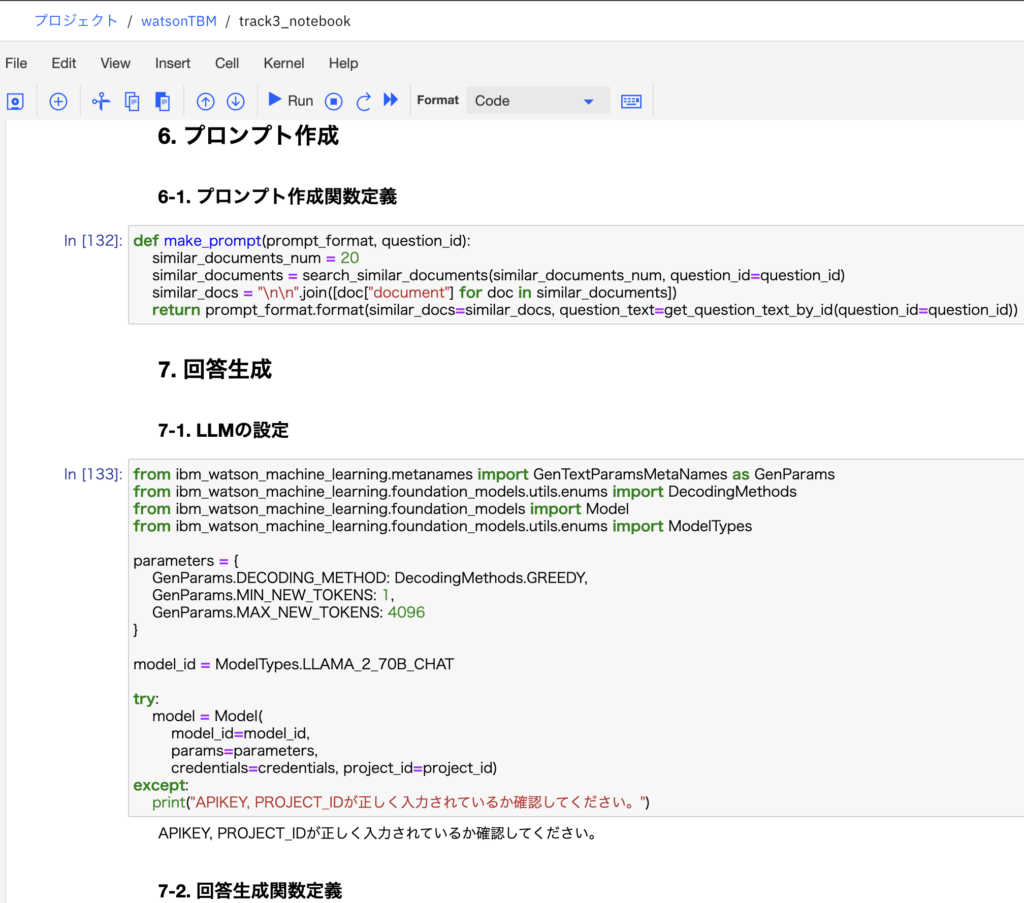

ChatGPTのステップ

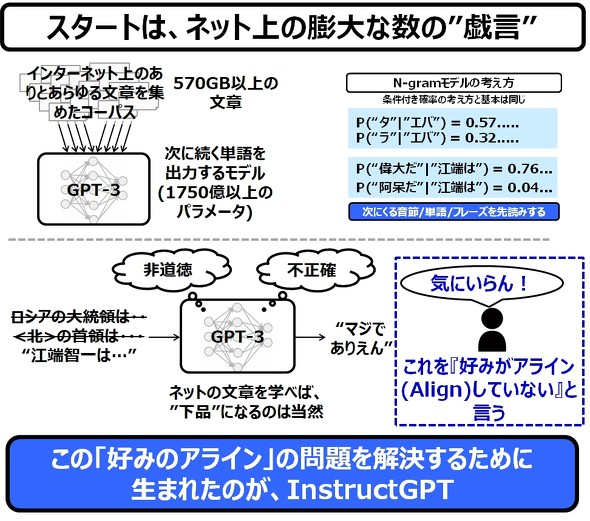

1. GPT-3の生成

LLM/Large Language Model=GPT-3を用意する。

例えば「日本の首都は、」に続く言葉を、膨大なインターネット上の文章から一番確率が高いものを、Deep learningにより「東京」「だ」と文章的に導出する。

2. InstructGPT

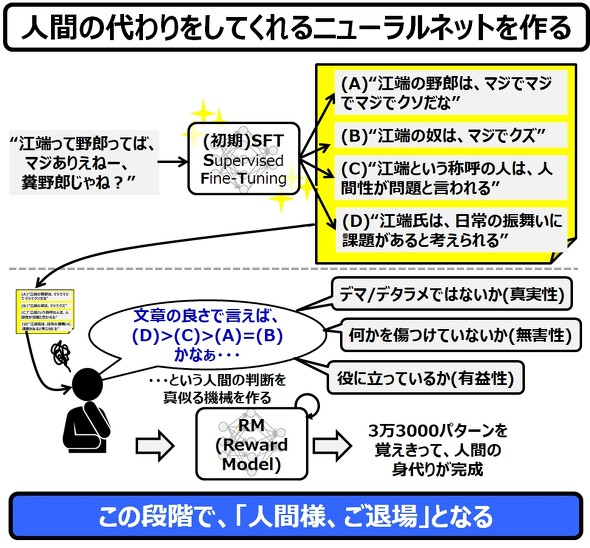

2.1 Supervised Fine-Tuning

InstructGPTと人力でGPT-3を再教育し、SFT/ファインチューニングGPTを作る。

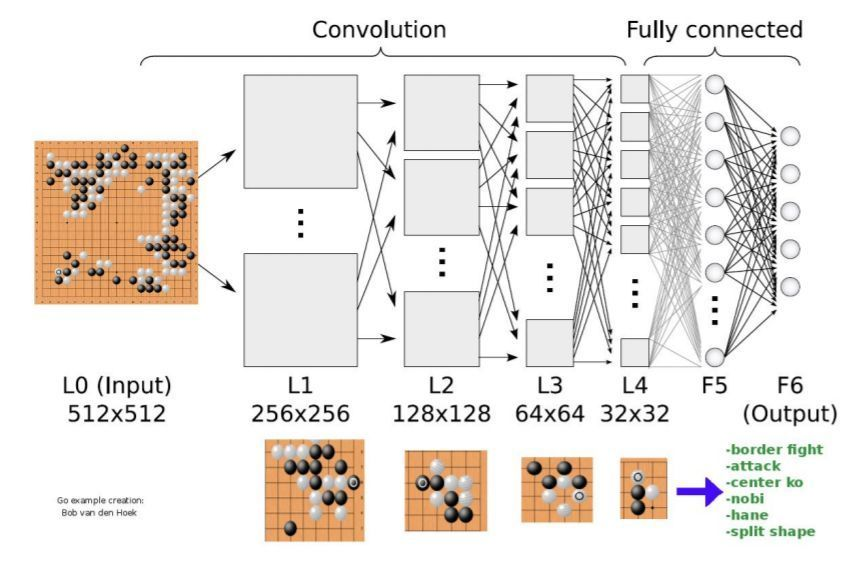

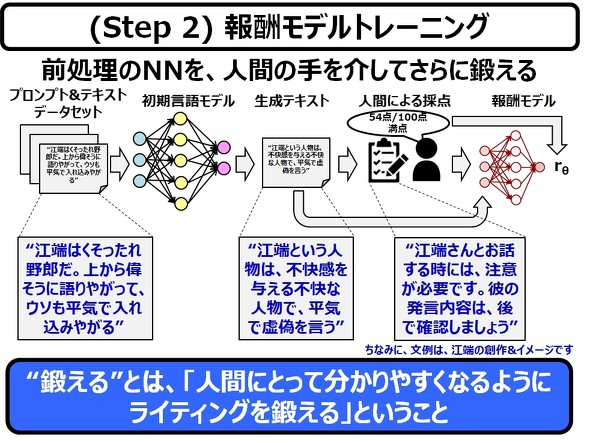

2.2 Rewarding Model

SFTからReward Modelで回答を向上させる。

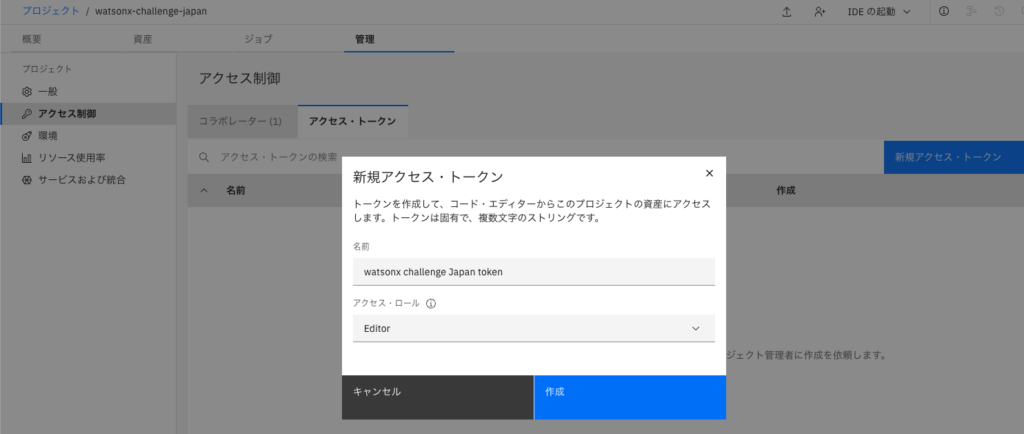

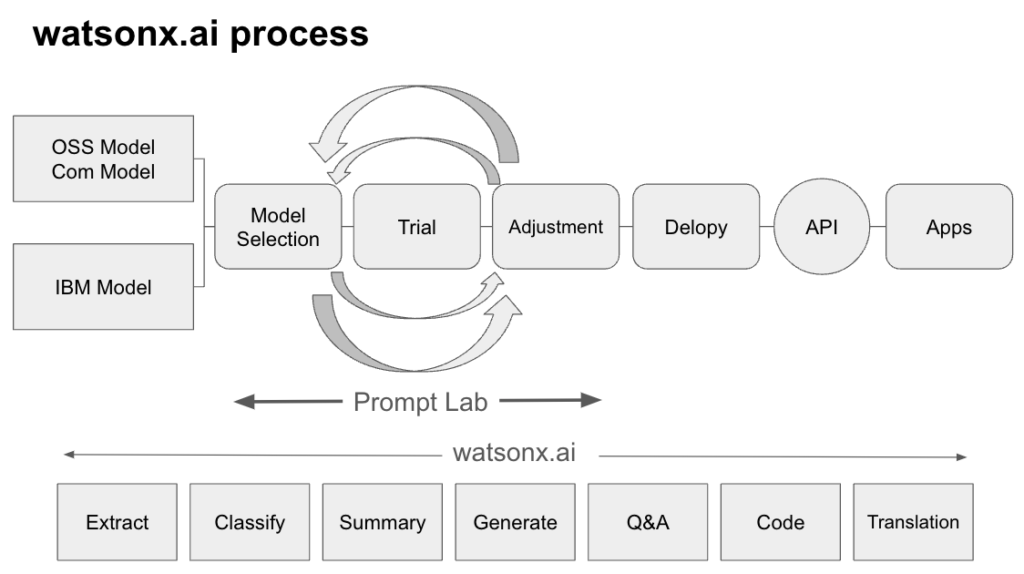

watsonxとは

watsonx製品ラインナップ

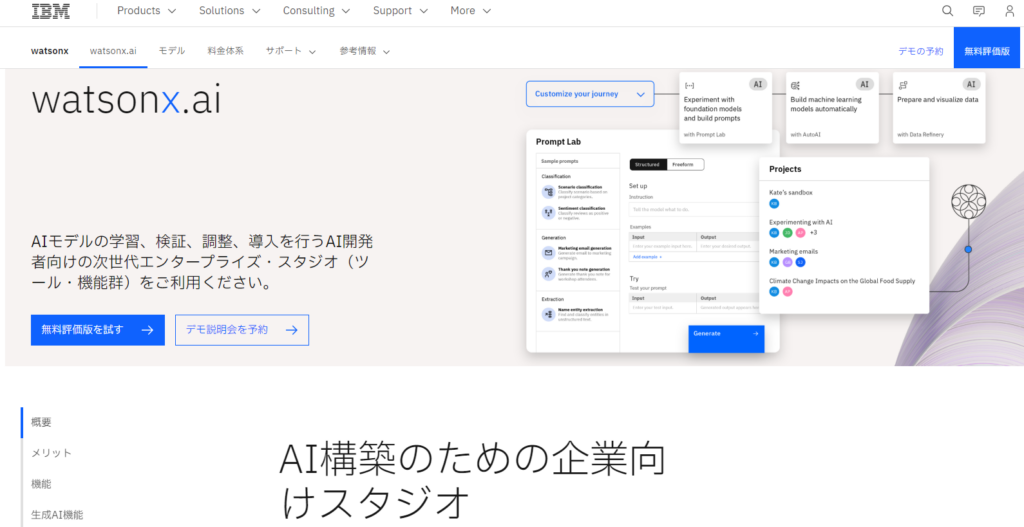

watsonx.ai スタジオ

watsonx.aiの機能

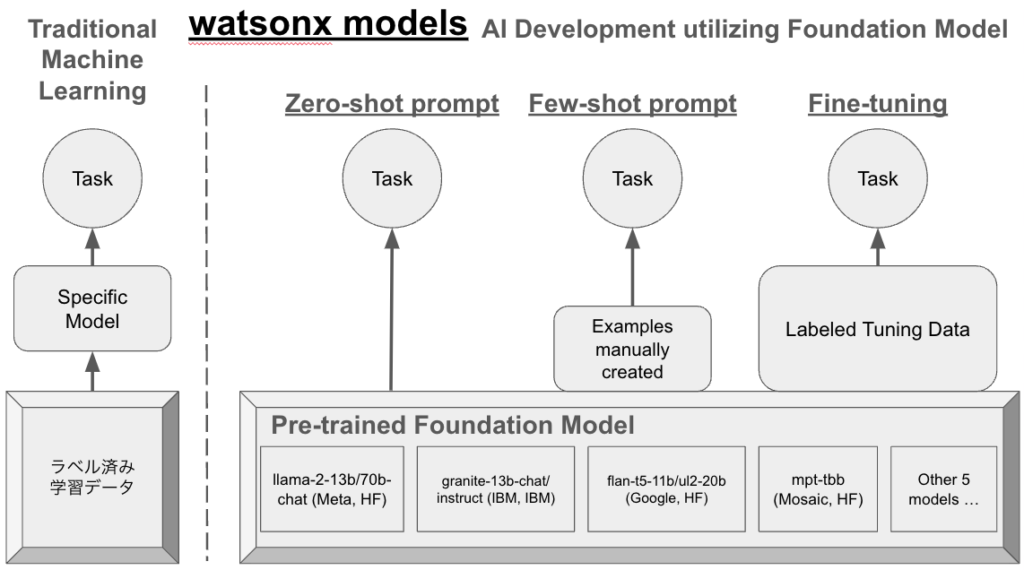

Pre-trained Foundation Modelとwatsonx

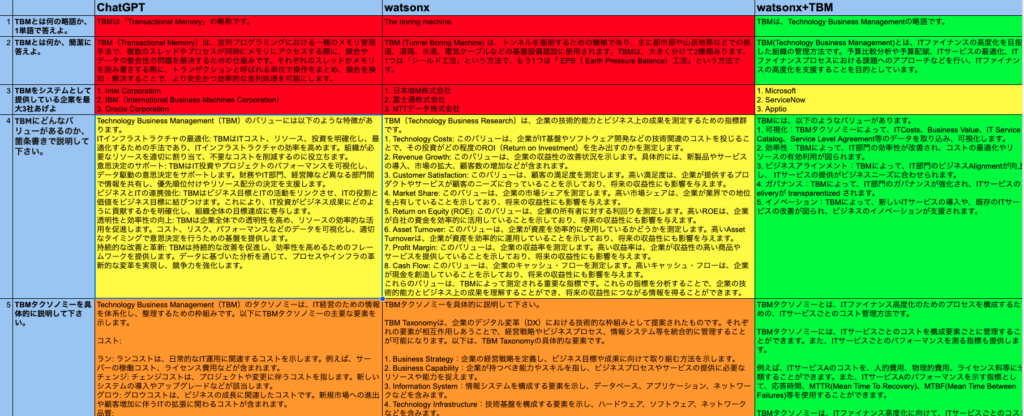

1. watsonx zeroshot prompt

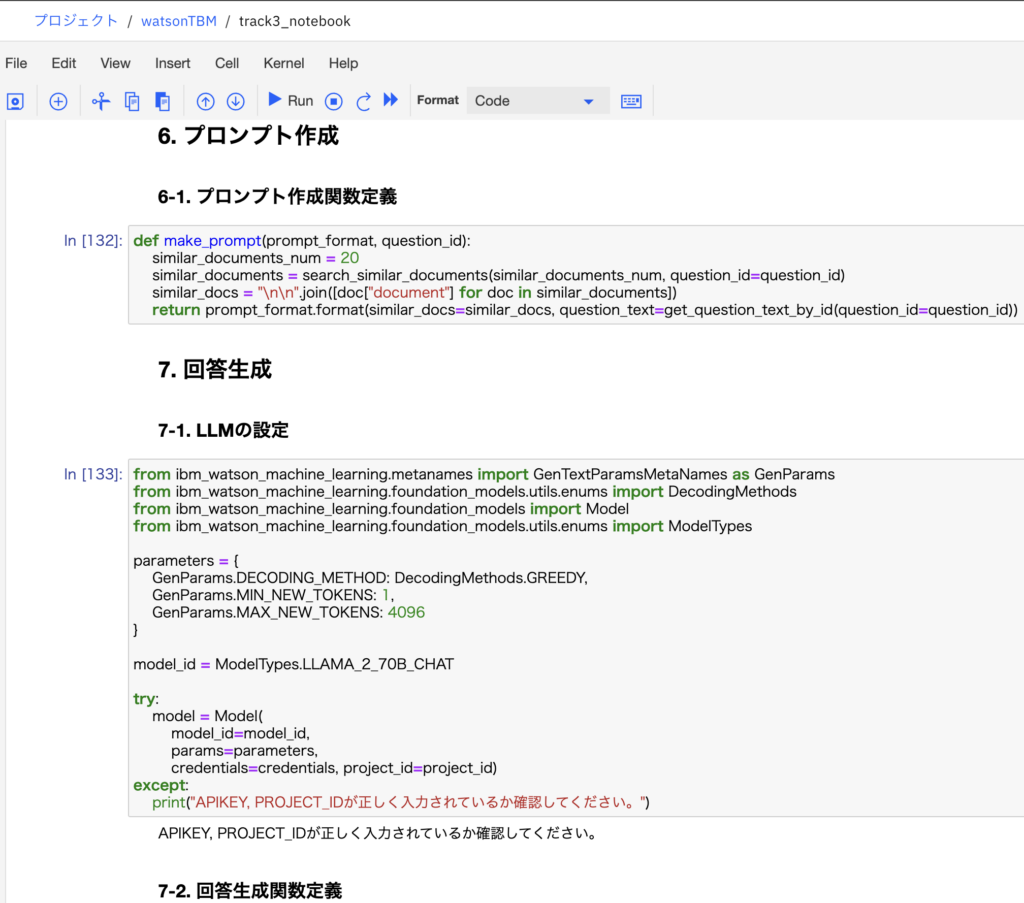

2. TBM-shot prompt

watsonx+TBMによるChatTBMの爆誕

Reference data from TBM book

Test results compared with ChatGPT, zeroshot (LLaMA) and ChatTBM

果たしてIBMは勝ち筋か、オープン化の歴史と比べてみる

オープン化の歴史

左はレガシーでクローズな悪の帝国連合、右はフリーで自由な挑戦者たち。たいていは自由な戦士たちが勝っているが、このAI戦争ではどっちが勝つのか??

| 年代 | Legacy Closed | Open Free |

| 1990年代 PC戦争 |  | |

| 1995年 インターネット ブラウザ戦争 |   |     |

| 2000年代 サーバーOS戦争 |  |   |

| 2000年代 検索戦争 |  | |

| 2005年代 スマホ戦争 |   |    |

| 2010年代 SNS戦争 |    |  |

| 2020年代 AI戦争 | Frontier Model | AI Alliance     … … |

AI Allianceとは

MetaとIBMが始めたAIのアライアンス – https://thealliance.ai/

GPT-4を含む生成AIの仕組みをもっと知るには